Back Total least squares#Geometrical interpretation English مجموع کمترین مربعات Persian Метод наименьших полных квадратов Russian

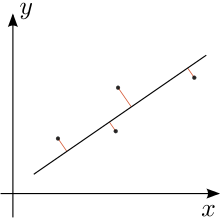

In der Statistik dient die orthogonale Regression (genauer: orthogonale lineare Regression) zur Berechnung einer Ausgleichsgeraden für eine endliche Menge metrisch skalierter Datenpaare nach der Methode der kleinsten Quadrate. Wie in anderen Regressionsmodellen wird dabei die Summe der quadrierten Abstände der von der Geraden minimiert. Im Unterschied zu anderen Formen der linearen Regression werden bei der orthogonalen Regression nicht die Abstände in - bzw. -Richtung verwendet, sondern die orthogonalen Abstände. Dieses Verfahren unterscheidet nicht zwischen einer unabhängigen und einer abhängigen Variablen. Damit können – anders als bei der linearen Regression – Anwendungen behandelt werden, bei denen beide Variablen und messfehlerbehaftet sind.

Die orthogonale Regression ist ein wichtiger Spezialfall der Deming-Regression. Sie wurde erstmals 1840 im Zusammenhang mit einem geodätischen Problem von Julius Weisbach angewendet[1][2], 1878 von Robert James Adcock in die Statistik eingeführt[3] und in allgemeinerem Rahmen 1943 von W. E. Deming für technische und ökonomische Anwendungen bekannt gemacht.[4]

- ↑ J. Weisbach: Bestimmung des Hauptstreichens und Hauptfallens von Lagerstätten. In: Archiv für Mineralogie, Geognosie, Bergbau und Hüttenkunde. Band 14, 1840, S. 159–174.

- ↑ D. Stoyan, T. Morel: Julius Weisbach's pioneering contribution to orthogonal linear regression. In: Historia Mathematica. Band 45, 2018, S. 75–84.

- ↑ R. J. Adcock: A problem in least squares. In: The Analyst. Band 5, Nr. 2. Annals of Mathematics, 1878, S. 53–54, doi:10.2307/2635758, JSTOR:2635758.

- ↑ W. E. Deming: Statistical adjustment of data. Wiley, NY (Dover Publications edition, 1985), 1943, ISBN 0-486-64685-8.